mac mini 安装 ollama

目录

警告

本文最后更新于 2025-03-15,文中内容可能已过时。

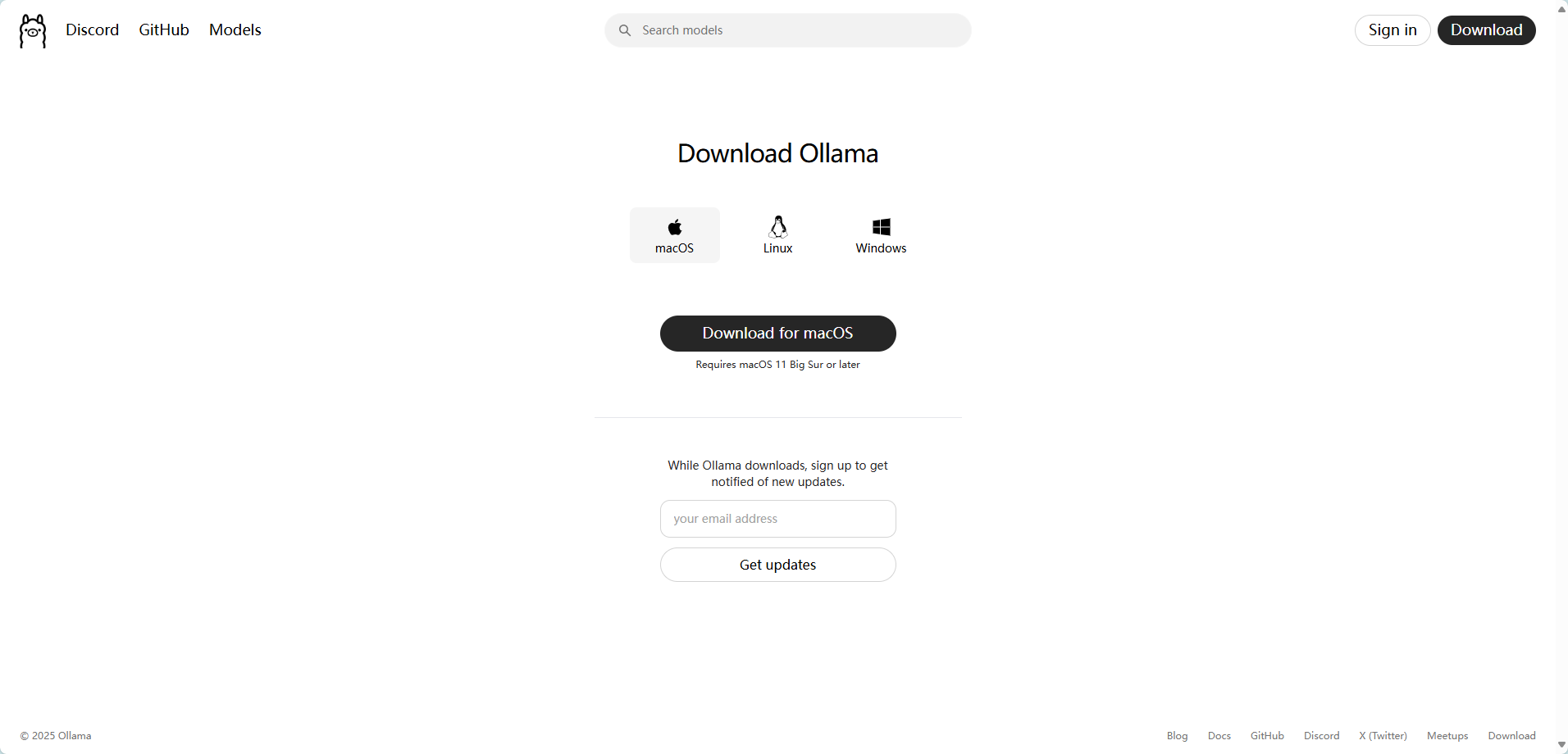

安装 ollama

网址:https://ollama.com/

图1)验证是否安装成功

浏览器访问 127.0.0.1:11434,显示 Ollama is running

|

|

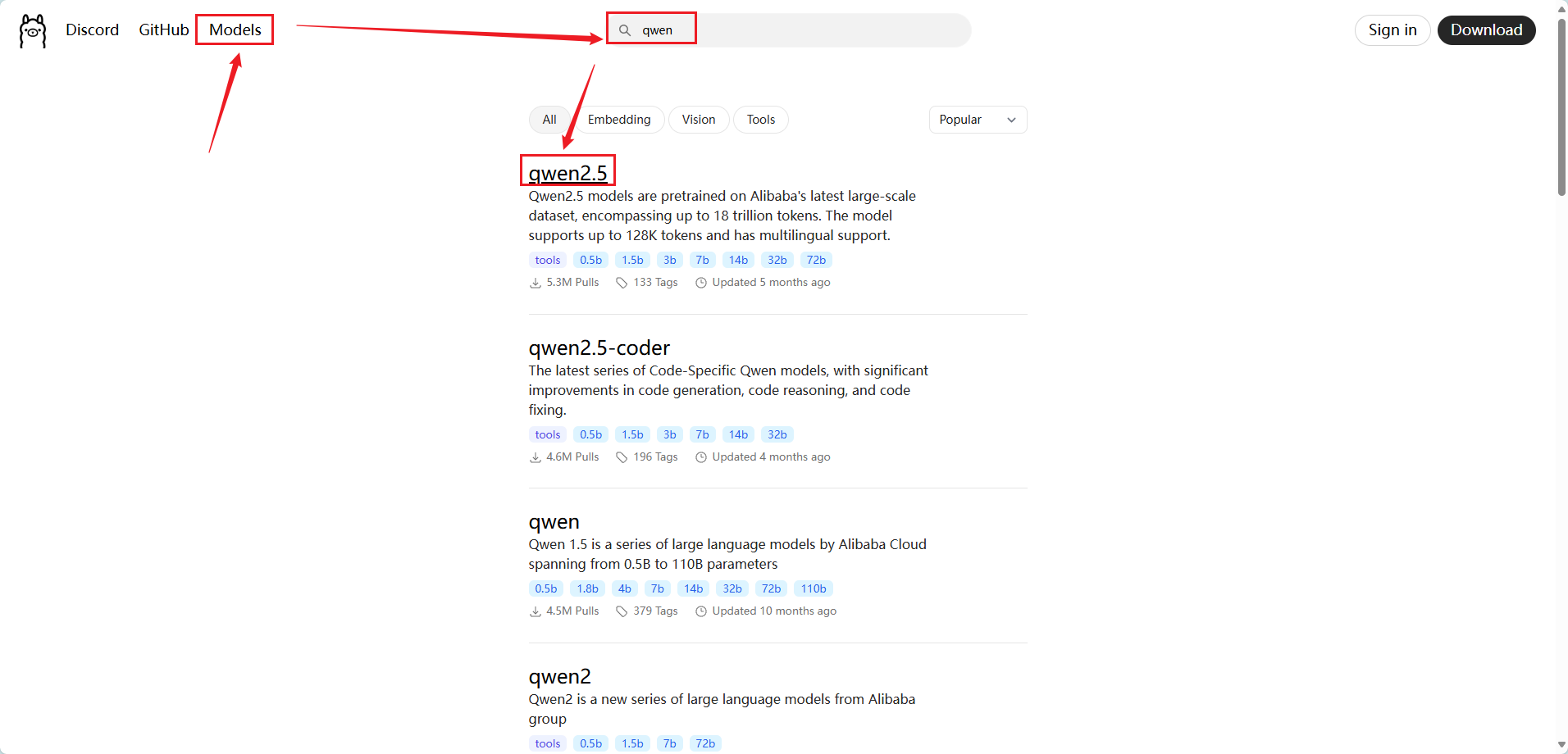

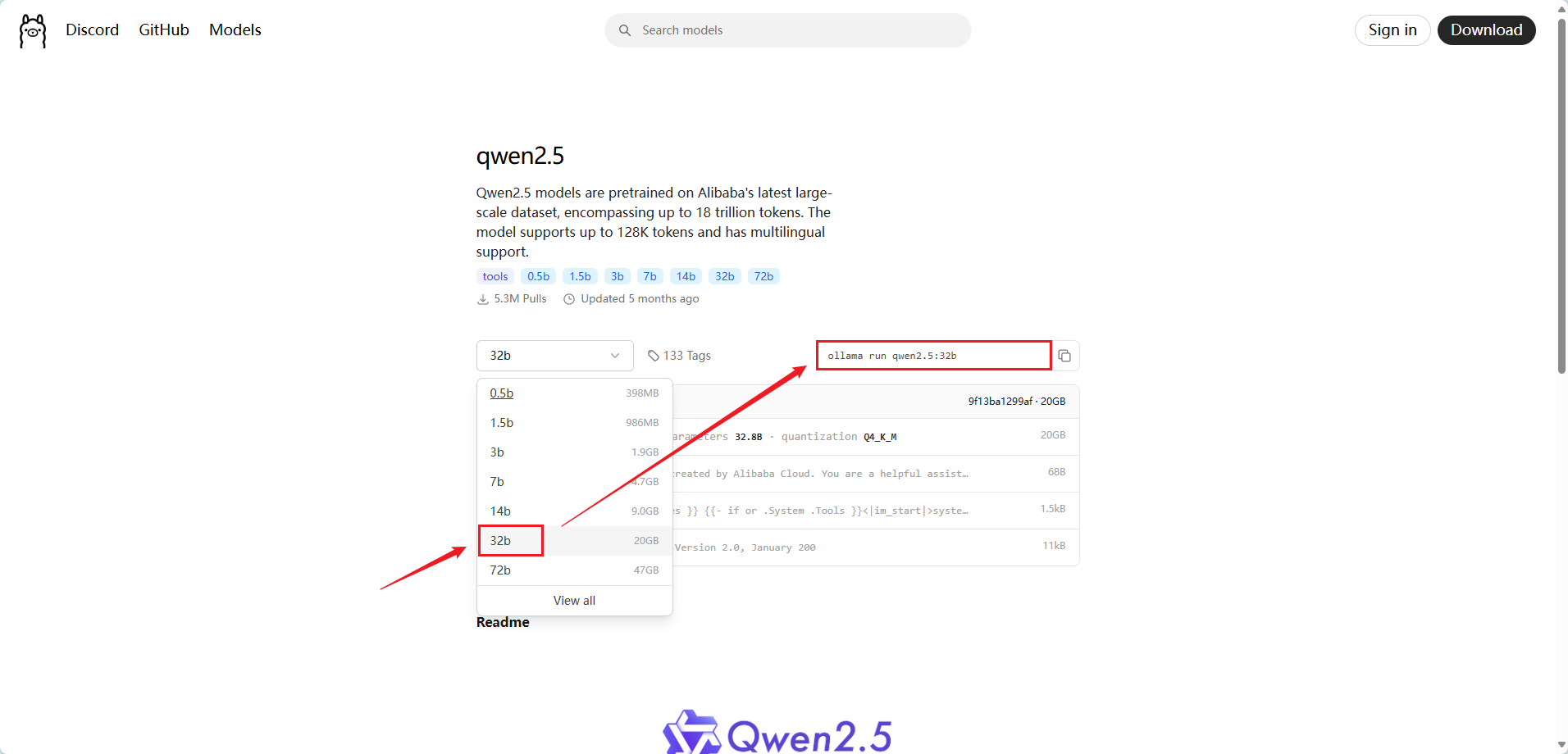

安装模型

图2)

图3)ollama 环境变量全解析

| 环境变量 | 功能说明 | 默认值/示例 |

|---|---|---|

| OLLAMA_HOST | 设置API服务监听地址与端口,0.0.0.0表示允许所有IP访问 | 0.0.0.0:11434 |

| OLLAMA_ORIGINS | 允许跨域请求的域名列表,*为通配符 | * |

| OLLAMA_MODELS | 自定义模型存储路径,避免占用系统盘空间 | D:\ollama_models |

| OLLAMA_KEEP_ALIVE | 控制模型在内存中的保留时间,减少重复加载开销 | 24h(24小时) |

| OLLAMA_NUM_PARALLEL | 并行处理请求数,提升高并发场景下的吞吐量 | 2 |

| OLLAMA_DEBUG | 启用调试日志,排查服务异常 | 1(开启) |

| OLLAMA_GPU_OVERHEAD | 扩展显存不足时,利用RAM/VRAM混合加载大模型(需手动计算显存值) | 81920000000(80GB) |

局域网调用模型api

ollama 默认监听的是 127.0.0.1:11434,局域网下的其他电脑是无法调通 ollama 的 api 的

方式一

|

|

方式二

|

|

方式三

|

|

ollama 模型常驻内存

方法一

|

|