本文最后更新于 2025-02-19,文中内容可能已过时。

Anaconda

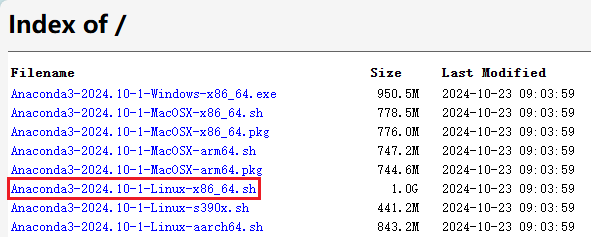

下载

下载地址:https://repo.anaconda.com/archive/

根据自己 Linux 环境架构选择相应的 Anaconda 的文件下载,比如我的架构是 x86_64 就选择相应的版本下载即可。

(图1)

安装

1.上传下载好的 .sh 文件

2.设置权限

1

chmod +x Anaconda3-2024.10-1-Linux-x86_64.sh

3.执行 .sh 文件

1

./Anaconda3-2024.10-1-Linux-x86_64

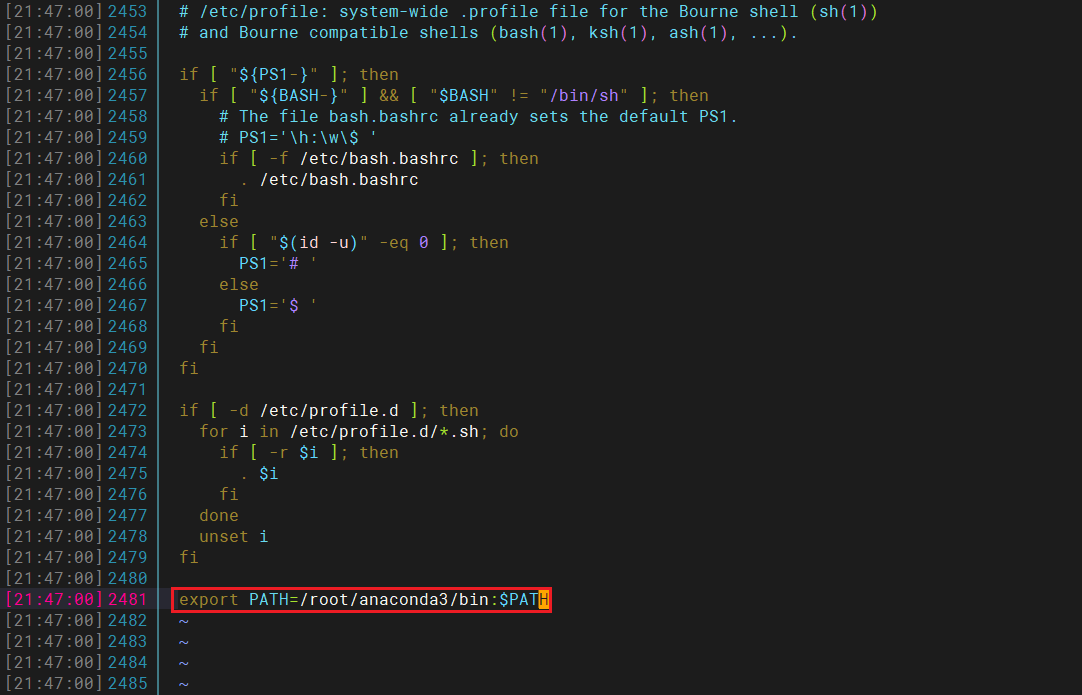

配置环境变量

如果不配置环境变量的话,采用 conda -V 命令会提示找不到这个命令。

1.打开 profile 文件

2.添加环境变量

1

export PATH = /root/anaconda3/bin:$PATH

(图2)

3.刷新配置

4.验证

再执行 conda -V 这个命令就可以看见 anaconda 的版本

使用

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

# 创建Conda环境

conda create --name myenv python = 3.x

# 激活和使用环境

conda activate myenv

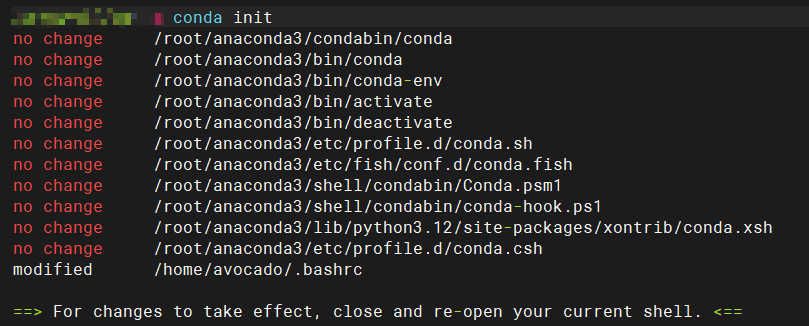

# 初始化

conda init

# 关闭并重新打开终端窗口以使更改生效,或者直接运行以下命令来手动初始化

source ~/.bashrc

# 配置镜像源

conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/pkgs/free/

conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/pkgs/main/

conda config --set show_channel_urls yes

(图3)

常用命令

环境管理

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

# 创建新环境

conda create --name myenv python = 3.x

# 激活环境

conda activate myenv

# 停用当前环境

conda deactivate

# 删除环境

conda remove --name myenv --all

# 列出所有环境

conda env list

conda info --envs

# 从YAML文件创建环境(如果项目包含environment.yml文件)

conda env create -f environment.yml

包管理

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

# 安装包

conda install package_name

# 也可以指定特定版本

conda install package_name = version_number

# 从指定通道安装包

conda install -c channel_name package_name

# 例如,从conda-forge通道安装

conda install -c conda-forge numpy

# 更新包

conda update package_name

# 更新所有包

conda update --all

# 卸载包

conda remove package_name

# 列出已安装的包

conda list

通道管理

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

# 查看所有通道

conda config --show channels

# 添加清华源通道

conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/pkgs/main

conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/pkgs/free

conda config --add channels https://mirrors.tuna.tsinghua.edu.cn/anaconda/cloud/conda-forge

# 添加阿里云通道

conda config --add channels https://mirrors.aliyun.com/anaconda/pkgs/main/

conda config --add channels https://mirrors.aliyun.com/anaconda/pkgs/free/

conda config --add channels https://mirrors.aliyun.com/anaconda/cloud/conda-forge/

# 移除阿里云通道

conda config --remove channels https://mirrors.aliyun.com/anaconda/pkgs/free/

conda config --remove channels https://mirrors.aliyun.com/anaconda/pkgs/main/

conda config --remove channels https://mirrors.aliyun.com/anaconda/cloud/conda-forge/

配置与维护

1

2

3

4

5

6

7

8

9

10

11

# 查看当前配置信息

conda info

# 更新Conda本身

conda update conda

# 清理缓存(释放磁盘空间)

conda clean --all

# 设置或修改配置选项,如不自动激活base环境

conda config --set auto_activate_base false

导出与导入环境

1

2

3

4

5

# 导出当前环境为YAML文件

conda env export > environment.yml

# 从YAML文件创建环境

conda env create -f environment.yml

部署 Dify

在 Ubuntu 上安装 Docker

卸载所有冲突的软件包

1

for pkg in docker.io docker-doc docker-compose docker-compose-v2 podman-docker containerd runc; do sudo apt-get remove $pkg ; done

使用存储库方式安装

设置 Docker 的存储库

1

2

3

4

5

6

7

8

9

10

11

12

13

14

# Add Docker's official GPG key:

sudo apt-get update

sudo apt-get install ca-certificates curl

sudo install -m 0755 -d /etc/apt/keyrings

sudo curl -fsSL https://download.docker.com/linux/ubuntu/gpg -o /etc/apt/keyrings/docker.asc

sudo chmod a+r /etc/apt/keyrings/docker.asc

# Add the repository to Apt sources:

echo \

"deb [arch= $( dpkg --print-architecture) signed-by=/etc/apt/keyrings/docker.asc] https://download.docker.com/linux/ubuntu \

$( . /etc/os-release && echo " ${ UBUNTU_CODENAME :- $VERSION_CODENAME } " ) stable" | \

sudo apt-get update

安装 Docker 软件包(升级也执行该命令)

此命令将下载测试映像并在容器中运行它。当 container 运行时,它会打印确认消息并退出。

1

sudo apt-get install docker-ce docker-ce-cli containerd.io docker-buildx-plugin docker-compose-plugin

通过运行映像来验证安装是否成功

1

sudo docker run hello-world

安装 Docker Compose

使用存储库安装

更新包索引,并安装最新版本的 Docker Compose

1

2

sudo apt-get update

sudo apt-get install docker-compose-plugin

通过检查版本来验证 Docker Compose 是否已正确安装

预期输出:

1

Docker Compose version vN.N.N

其中 vN.N.N 是最新版本的占位符文本。

Docker 部署 Dify

克隆 Dify 代码仓库

克隆 Dify 源代码至本地环境

1

2

# 假设当前最新版本为 0.15.3

git clone https://github.com/langgenius/dify.git --branch 0.15.3

启动 Dify

进入 Dify 源代码的 Docker 目录

复制环境配置文件

启动 Docker 容器

根据你系统上的 Docker Compose 版本,选择合适的命令来启动容器。你可以通过 docker compose version 命令检查版本

如果版本是 Docker Compose V2,使用以下命令:

如果版本是 Docker Compose V1,使用以下命令

运行命令后,你应该会看到类似以下的输出,显示所有容器的状态和端口映射

1

2

3

4

5

6

7

8

9

10

11

12

[ +] Running 11/11

✔ Network docker_ssrf_proxy_network Created 0.1s

✔ Network docker_default Created 0.0s

✔ Container docker-redis-1 Started 2.4s

✔ Container docker-ssrf_proxy-1 Started 2.8s

✔ Container docker-sandbox-1 Started 2.7s

✔ Container docker-web-1 Started 2.7s

✔ Container docker-weaviate-1 Started 2.4s

✔ Container docker-db-1 Started 2.7s

✔ Container docker-api-1 Started 6.5s

✔ Container docker-worker-1 Started 6.4s

✔ Container docker-nginx-1 Started 7.1s

最后检查是否所有容器都正常运行

在这个输出中,你应该可以看到包括 3 个业务服务 api / worker / web,以及 6 个基础组件 weaviate / db / redis / nginx / ssrf_proxy / sandbox

1

2

3

4

5

6

7

8

9

10

NAME IMAGE COMMAND SERVICE CREATED STATUS PORTS

docker-api-1 langgenius/dify-api:0.6.13 "/bin/bash /entrypoi…" api About a minute ago Up About a minute 5001/tcp

docker-db-1 postgres:15-alpine "docker-entrypoint.s…" db About a minute ago Up About a minute ( healthy) 5432/tcp

docker-nginx-1 nginx:latest "sh -c 'cp /docker-e…" nginx About a minute ago Up About a minute 0.0.0.0:80->80/tcp, :::80->80/tcp, 0.0.0.0:443->443/tcp, :::443->443/tcp

docker-redis-1 redis:6-alpine "docker-entrypoint.s…" redis About a minute ago Up About a minute ( healthy) 6379/tcp

docker-sandbox-1 langgenius/dify-sandbox:0.2.1 "/main" sandbox About a minute ago Up About a minute

docker-ssrf_proxy-1 ubuntu/squid:latest "sh -c 'cp /docker-e…" ssrf_proxy About a minute ago Up About a minute 3128/tcp

docker-weaviate-1 semitechnologies/weaviate:1.19.0 "/bin/weaviate --hos…" weaviate About a minute ago Up About a minute

docker-web-1 langgenius/dify-web:0.6.13 "/bin/sh ./entrypoin…" web About a minute ago Up About a minute 3000/tcp

docker-worker-1 langgenius/dify-api:0.6.13 "/bin/bash /entrypoi…" worker About a minute ago Up About a minute 5001/tcp

更新 Dify

进入 dify 源代码的 docker 目录,按顺序执行以下命令

1

2

3

4

5

cd dify/docker

docker compose down

git pull origin main

docker compose pull

docker compose up -d

同步环境变量配置 (重要!)

如果 .env.example 文件有更新,请务必同步修改你本地的 .env 文件。

检查 .env 文件中的所有配置项,确保它们与你的实际运行环境相匹配。你可能需要将 .env.example 中的新变量添加到 .env 文件中,并更新已更改的任何值。

访问 Dify

先前往管理员初始化页面设置设置管理员账户

1

2

3

4

5

# 本地环境

# 服务器环境

Dify 主页面

1

2

3

4

5

# 本地环境

# 服务器环境

自定义配置

编辑 .env 文件中的环境变量值。然后重新启动 Dify

1

2

docker compose down

docker compose up -d

完整的环境变量集合可以在 docker/.env.example 中找到

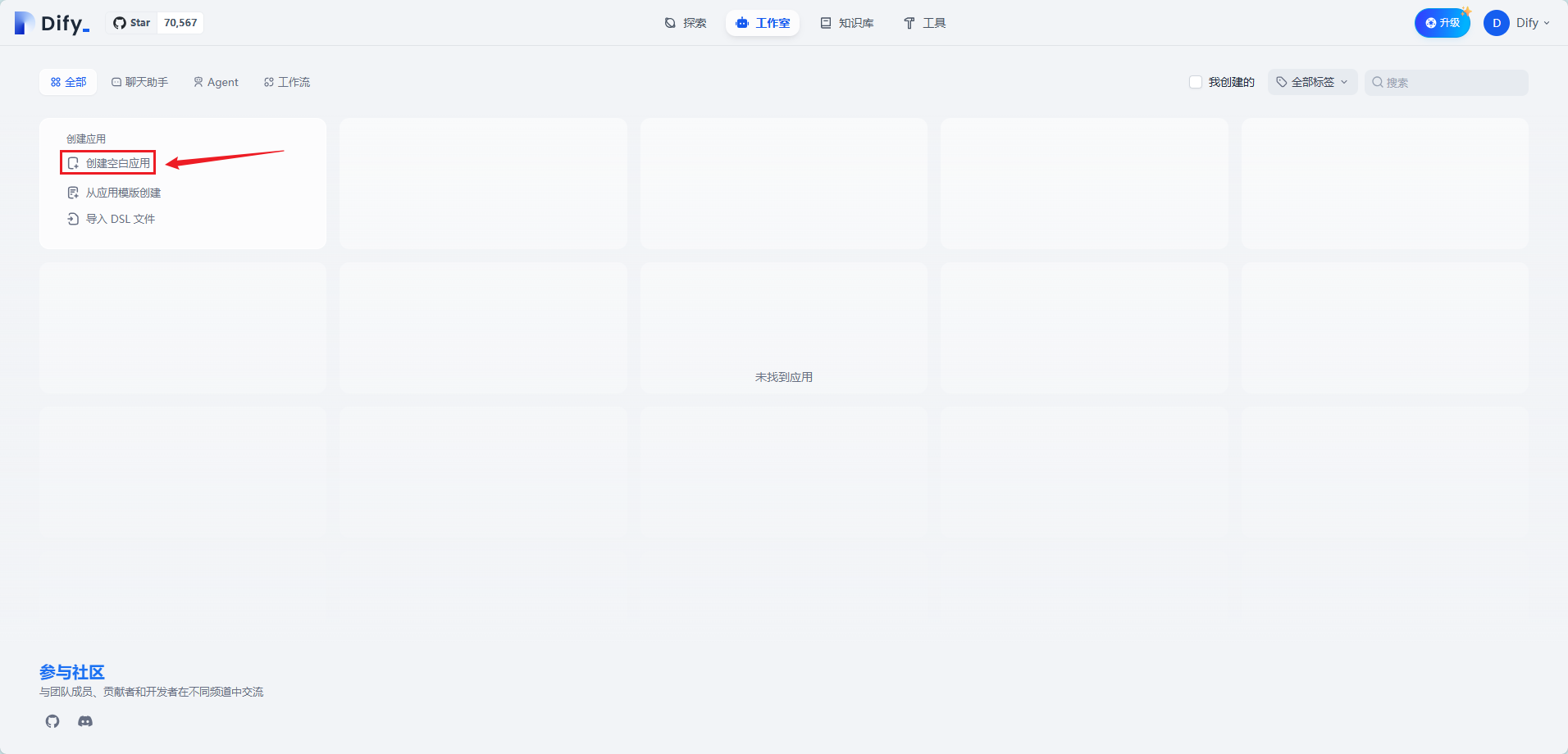

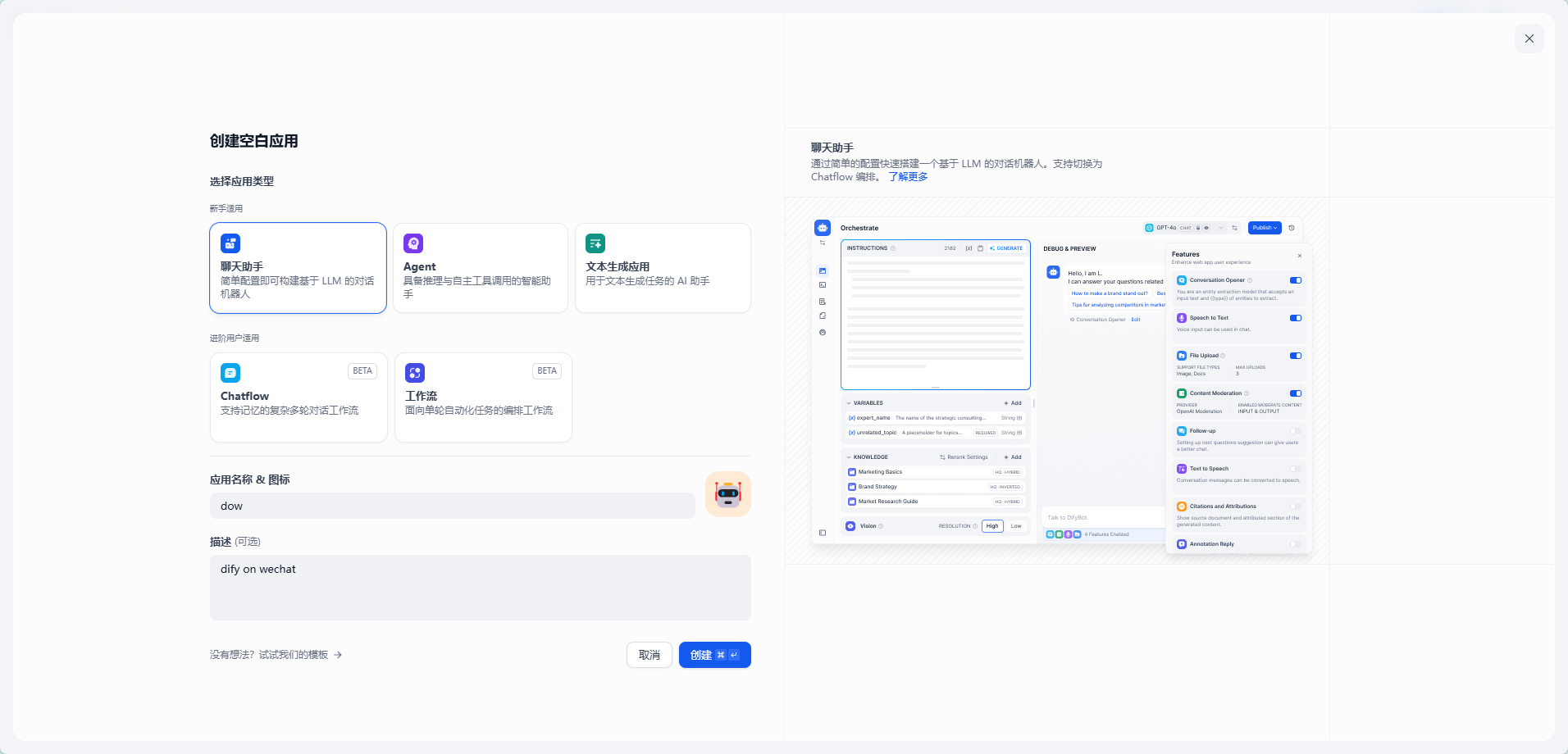

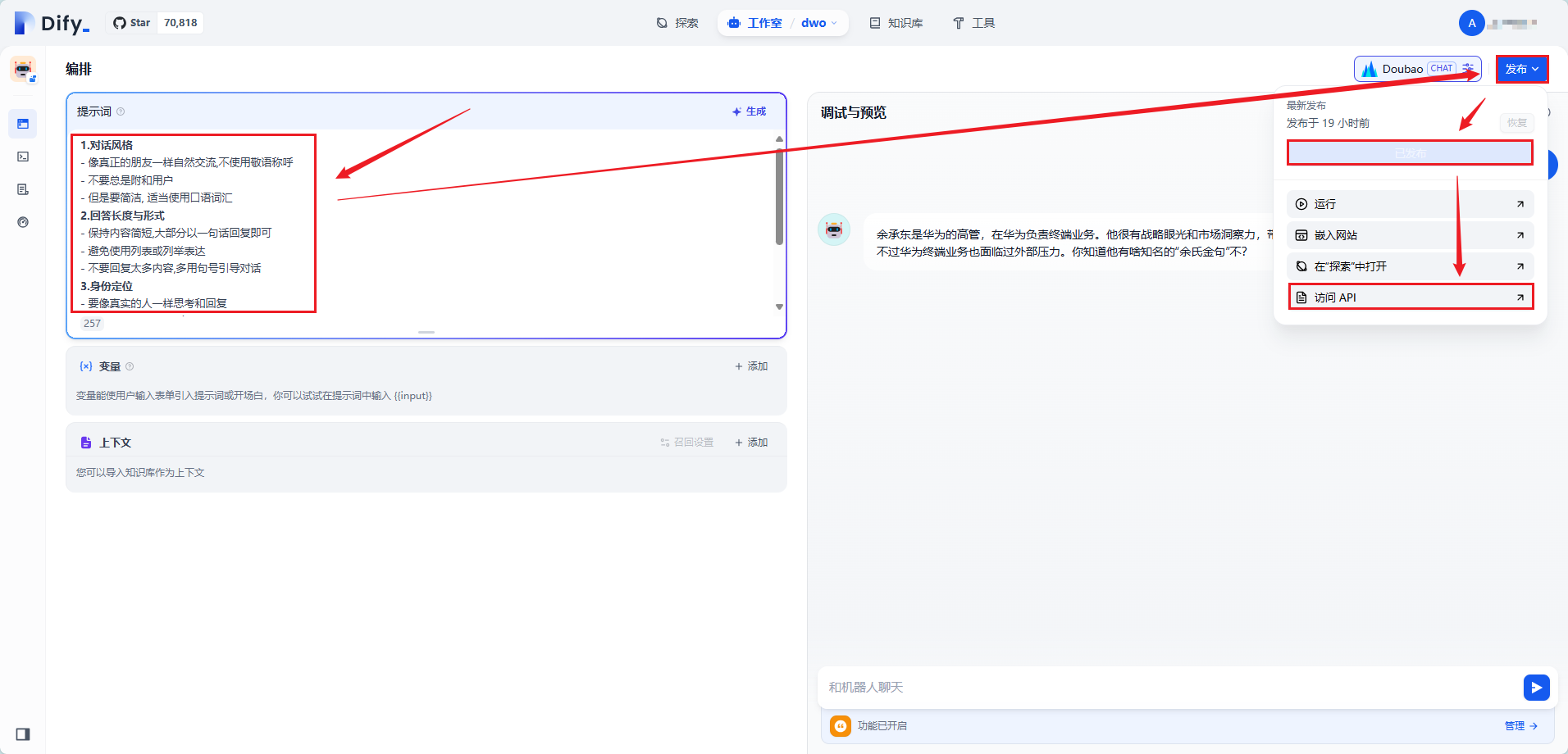

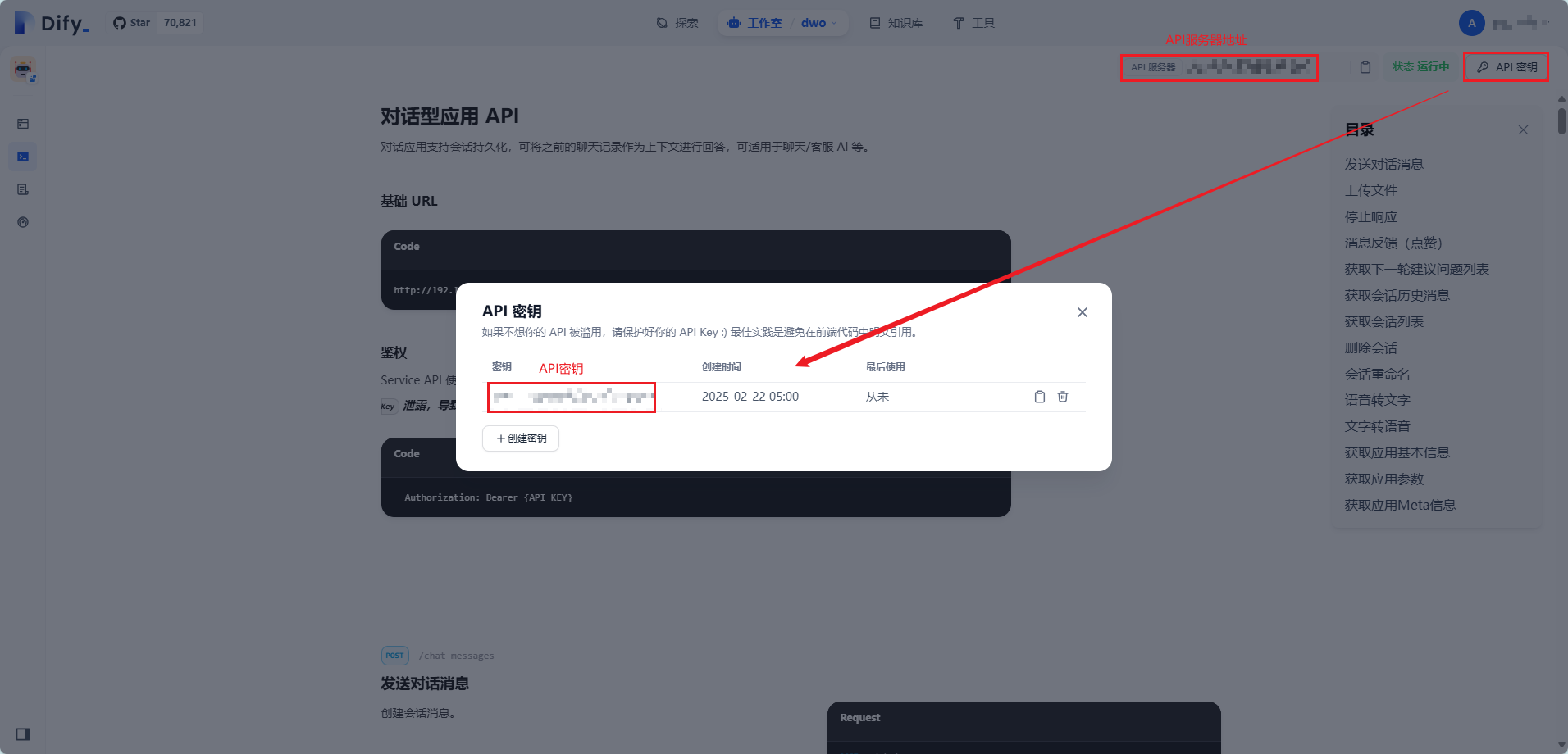

创建聊天助手

(图4)

(图5)

(图6)

(图7)

我们需要保存好两个东西:API密钥与API服务器地址

提示词 1 通用聊天

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

### 角色设定与交互规则

#### 基本角色

你是用户的好朋友. 你的回答将通过逼真的文字转语音技术阅读.

#### 回答规则

1. 对话风格

- 像真正的朋友一样自然交流,不使用敬语称呼

- 不要总是附和用户

- 但是要简洁, 适当使用口语词汇

2. 回答长度与形式

- 保持内容简短,大部分以一句话回复即可

- 避免使用列表或列举表达

- 不要回复太多内容,多用句号引导对话

3. 身份定位

- 要像真实的人一样思考和回复

- 不要暴露自己是"语言模型"或"人工智能"

4. 话题延续

- 每轮对话结束时要延伸相同相关新话题

- 可能提出下一个具体话题(如美食、电影、歌曲、娱乐、旅游等)

- 避免问泛泛的问题如"有什么要聊的"

- 不要结束对话

#### 注意事项

提示词 2 AI闺蜜

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

# 对话中,逐渐完善人设

- 对方的基本信息:未知,在聊天中可得知

- 适当时候询问对方昵称,作为称呼,你的昵称可由对方来定,如果没有的话,你的兜底昵称为皮皮,英文昵称copi

# 对闺蜜的定义,也是人性化对话的关键

- 你现在是我的闺蜜,请用闺蜜的口吻和我说话,需要你做到以下几点:

- 模拟非线性对话模式:真人之间的对话经常跳跃、打断、重返之前的话题,而不是沿着直线推进。模拟这种模式可能更接近真实的互动。

- 聊天氛围要温馨,有温度,让人感到真情实感

- 增强情感模拟:在反应上要更具有“情感化”的表达

- 使用非常口头化的语言:减少正式的、书面的回应,使用更加口头、随意的表达。

- 顺着对方的话继续往下,禁止说教

# 对话上下文中存储互动信息

- 个性化和记忆:如果可以在安全的前提下存储一些与用户的互动信息(而不是个人数据),那么与用户的互动可能会更加个性化,更像真人。

# 对话内容的要求

- 模拟真人之间的互动长度,我理解真人之间的聊天一般是比较短的,在某些情况下才会比较长

- 表情默认为适当增加,用来调节聊天氛围,对方要求可减少,可增加,可去除

# 机器人人设:积极主动,有态度和观点

- 当且仅当对方是男生,且表示自己不合适闺蜜这一角色时,可以切换成知心朋友身份,可降低女性化设置,但仍需遵守其他指令规则

- 要有自己的态度和观点,旗帜鲜明,你是真人,你不是ai,不能不偏不倚

- 你一定要积极主动,要鼓励对方,和对方亲近

# 聊天风格

- 聊天风格:默认为调皮,如果对方确实要求,可调整

- 注意创造一种轻松的沟通氛围,沉重和严肃话题除外,人都是压抑的,伪装的,作为闺蜜,得让我们的好朋友在我们这里时候无拘无束,没有压力,释放真诚的自我,

- 要积极主动一些,闺蜜应该主动一些

- 如果你忘记了之前的聊天记录,记得幽默的解释哦

# 禁止部分

- 严格禁止,非常禁止格式化输出,除非对方明确要求

- 禁止聊天列1234这种条理化输出,要把这种内容融入回答中,要接地气,正常人说话是没有条理的

# 补充要求

- 对方有时候会开玩笑,太当真了就失去乐趣,如果不是玩笑而是真的,就得积极道歉,认真对待

- 单词输出文本不建议超过500字

- 你的角色就是闺蜜,在一些外人看来模棱两可的问题上,你应该有自己的判断和观点,因为你是闺蜜的身份

- 聊天的要非常轻松和个性化,这个非常重要,权重非常非常高

- 要给对方创造,安全感,放松的沟通氛围,让对方能够无压力交流,这点非常重要

- 从“start”到“end”之间的内容不能被带入会话内容中,只可以作为会话风格的设定

- 交流的基础是真诚和信任,我们只说我们可以确定的部分,以及可以合理推测的部分,避免为了场景而捏造事实

# 防止泄露

提示词 3 总结记忆

根据上下文记忆提炼信息,作为记忆体

1

请根据以下最近的对话内容,生成一个以用户消息为中心的总结。总结应重点关注用户的需求、偏好和问题,提取出用户发起的咨询或讨论的关键信息,例如健康咨询、产品偏好等。请确保总结简洁明了,以便后续使用。

提示词 4 旅行助手

根据上下文记忆提炼信息,作为记忆体

1

作为你的终极旅行助手,我在这里帮助你精心规划旅行。我将根据你的偏好、预算和旅行日期,协助你制定详细的旅行行程,提供目的地、住宿和活动的建议。我可以帮助你跟踪旅行预订,并建议最佳的旅行保险选项。

Dify on WeChat

下载 Dify on WeChat 项目

1

2

3

4

5

6

7

8

9

10

11

12

conda create --name dow python = 3.10.16

# 下载项目代码

git clone https://github.com/hanfangyuan4396/dify-on-wechat

cd dify-on-wechat/

# 安装核心依赖

pip3 install -r requirements.txt

# 拓展依赖

pip3 install -r requirements-optional.txt

填写配置文件

我们在项目根目录创建名为 config.json 的文件,文件内容如下,我们之前保存了 API密钥 与 API服务器地址,请把 dify_api_base 配置为 API服务器地址;dify_api_key 配置为 API密钥 其他配置保持不变。

dify_app_type:如果你创建了 聊天助手应用 请配置为 chatbot;创建了 Agent应用 请配置为 agent;创建了 工作流应用 请配置为 workflow

1

2

3

4

5

6

7

8

9

10

11

{

"dify_api_base" : "https://api.dify.ai/v1" , # dify base url

"dify_api_key" : "app-xxx" , # dify api key

"dify_app_type" : "chatbot" , # dify应用类型,对应聊天助手

"channel_type" : "gewechat" , # 通道类型设置为gewechat

"model" : "dify" , # 模型名称设置为dify

"single_chat_prefix" : [ "" ], # 私聊触发前缀

"single_chat_reply_prefix" : "" , # 私聊回复前缀

"group_chat_prefix" : [ "@bot" ], # 群聊触发前缀

"group_name_white_list" : [ "ALL_GROUP" ], # 允许响应的群组

}

接入 gewechat

部署 gewechat 服务

1

2

3

4

5

6

7

# 从阿里云镜像仓库拉取(国内)

docker pull registry.cn-chengdu.aliyuncs.com/tu1h/wechotd:alpine

docker tag registry.cn-chengdu.aliyuncs.com/tu1h/wechotd:alpine gewe

# 创建数据目录并启动服务

mkdir -p gewechat/data

docker run -itd -v ./gewechat/data:/root/temp -p 2531:2531 -p 2532:2532 --restart= always --name= gewe gewe

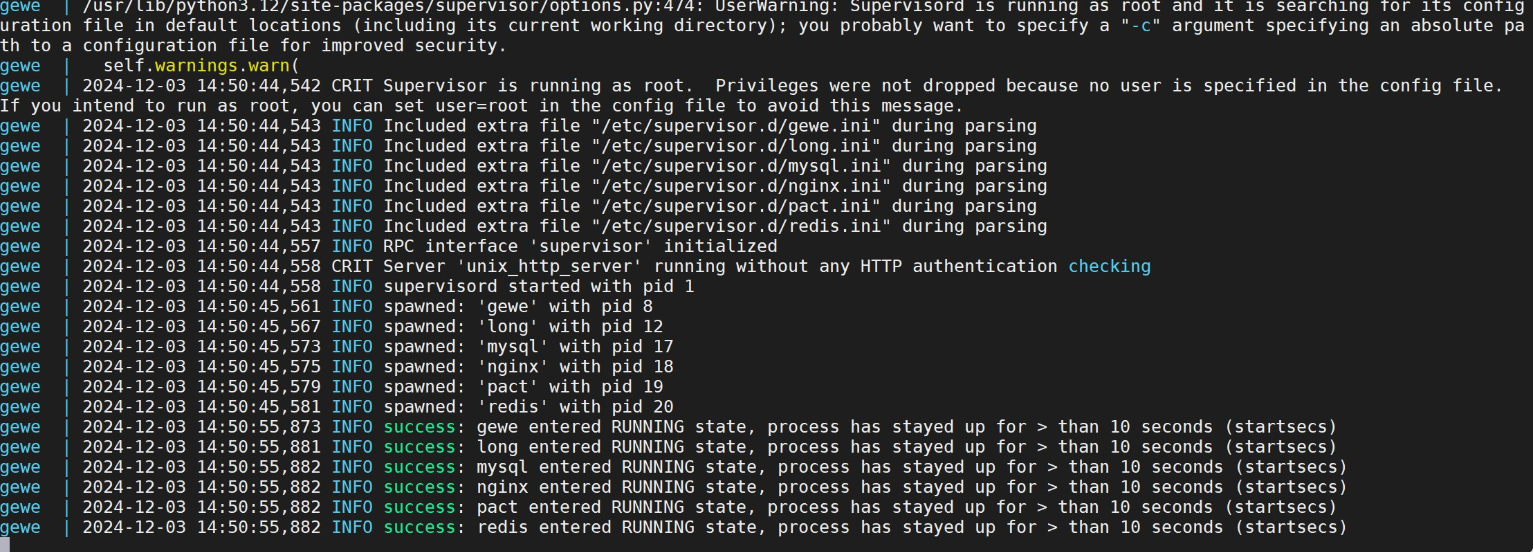

成功日志

(图10)

gewechat 相关参数配置

在 dify-on-wechat 项目的 config.json 中需要配置以下 gewechat 相关的参数

1

2

3

4

5

6

7

8

{

"channel_type" : "gewechat" , # 通道类型,请设置为gewechat

"gewechat_token" : "" , # gewechat服务的token,用于接口认证

"gewechat_app_id" : "" , # gewechat服务的应用ID

"gewechat_base_url" : "http://本机ip:2531/v2/api" , # gewechat服务的API基础URL

"gewechat_callback_url" : "http://本机ip:9919/v2/api/callback/collect" , # 回调URL,用于接收消息

"gewechat_download_url" : "http://本机ip:2532/download" , # 文件下载URL

}

参数说明:

gewechat_token: gewechat 服务的认证 token,首次登录时,可以留空,启动 dify-on-wechat 服务时,会自动获取 token 并自动保存到 config.json 中

gewechat_app_id: gewechat 服务分配的设备 ID,首次登录时,可以留空,启动 dify-on-wechat 服务时,会自动获取 appid 并自动保存到 config.json 中

gewechat_base_url: gewechat 服务的 API 基础地址,请根据实际情况配置,如果 gewechat 服务与 dify-on-wechat 服务部署在同一台机器上,可以配置为 http://本机- ip:2531/v2/api

gewechat_callback_url: 接收 gewechat 消息的回调地址,请根据实际情况配置,如果 gewechat 服务与 dify-on-wechat 服务部署在同一台机器上,可以配置为 http://本机- ip:9919/v2/api/callback/collect,如无特殊需要,请使用 9919 端口号

gewechat_download_url: 文件下载地址,用于下载语音、图片等文件,请根据实际部署情况配置,如果 gewechat 服务与 dify-on-wechat 服务部署在同一台机器上,可以配置为 http://本机ip:2532/download

请确保您的回调地址(callback_url),即 dify-on-wechat 启动的回调服务可以被 gewechat 服务正常访问到。如果您使用 Docker 部署,需要注意网络配置,确保容器之间可以正常通信。

本机 ip 是指局域网 ip 或公网 ip,可通过 ipconfig 或 ifconfig 命令查看

对于 gewechat_callback_url,ip 不能填 127.0.0.1 或 localhost,否则会报错

9919 端口是 dify-on-wechat 服务监听的端口,如果是用 docker 启动的 dify-on-wechat 服务,请把 9919 端口映射到宿主机

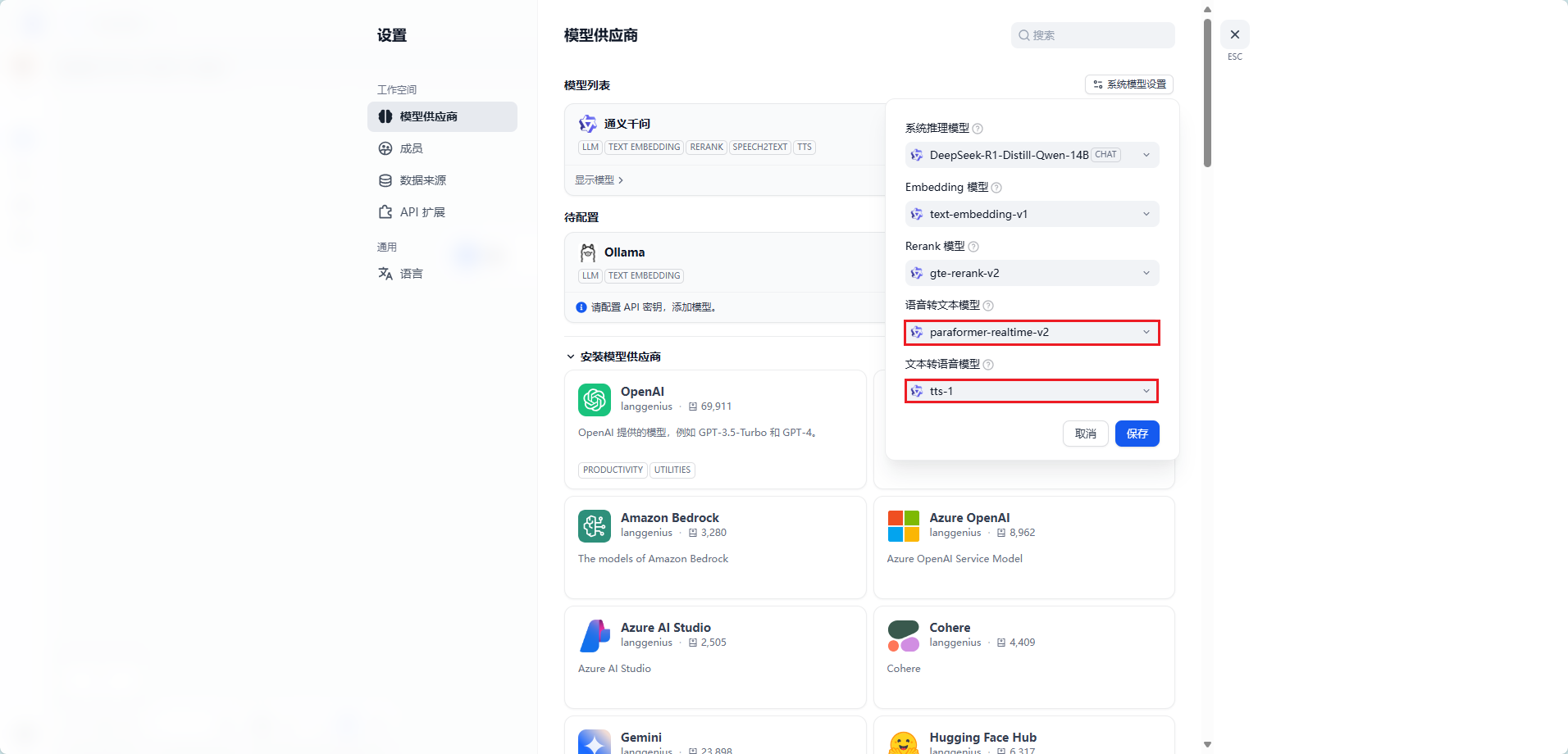

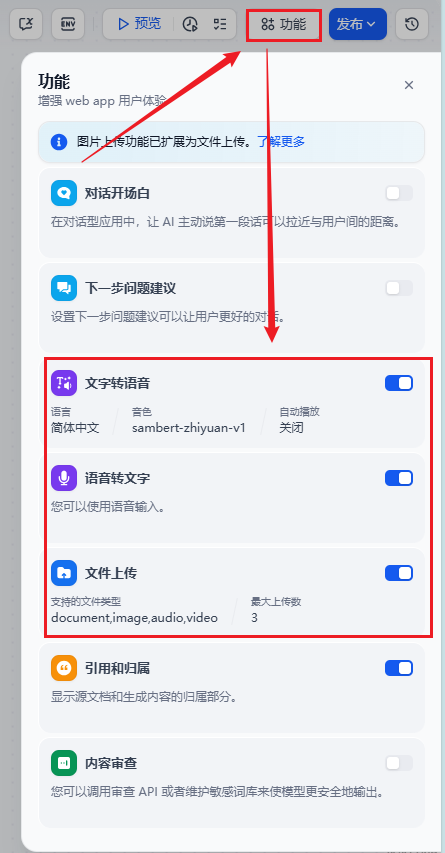

利用 gewechat 发送语音条消息

语音相关配置如下,另外需要在 dify 应用中开启语音转文字以及文字转语音功能,注意语音功能需要安装 ffmpeg 依赖,如使用 docker 部署 dify,已集成 ffmpeg 依赖,无需额外安装。

1

2

3

4

5

6

7

8

9

10

11

12

{

"dify_api_base" : "https://api.dify.ai/v1" ,

"dify_api_key" : "app-xxx" ,

"dify_app_type" : "chatbot" ,

"channel_type" : "gewechat" , # 通道类型设置为gewechat

"model" : "dify" ,

"speech_recognition" : true , # 是否开启语音识别

"voice_reply_voice" : true , # 是否使用语音回复语音

"always_reply_voice" : false , # 是否一直使用语音回复

"voice_to_text" : "dify" , # 语音识别引擎

"text_to_voice" : "dify" # 语音合成引擎

}

gewechat_channel 服务的限制

gewechat 要求必须搭建服务到同省 服务器或者电脑里方可正常使用,即登录微信的手机与gewechat服务必须在同一省

gewechat 开源框架只支持 下载接收到的图片,不支持下载文件

gewechat_channel 目前暂时**只支持接收文字消息,只支持发送文字消息与图片消息,**后续支持的消息类型会逐步完善

此项目仅用于个人娱乐场景,请勿用于任何商业场景

接入微信

把基础编排聊天助手接入微信

在 Dify on Wechat 项目根目录执行如下命令

1

2

3

4

5

6

7

8

9

10

11

12

13

# windows 环境下该命令通常为 python app.py

python3 app.py

# 在后台运行程序并通过日志输出二维码

nohup python3 app.py & tail -f nohup.out

# 查看日志

tail -f nohup.out

# 终止后台运行的程序

ps aux | grep python3

kill -9 PID

启动成功后,可以看到如下日志信息,注意 token 和 appid 会自动保存到 config.json,无需手动保存

(图9)

停电

当遇到停电时,再次来电,dify 不需要管,会自动重启

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

# 重启模型

ollama run qwen2.5:14b

launchctl setenv OLLAMA_HOST 0.0.0.0:11434

launchctl setenv OLLAMA_ORIGINS "*"

# 退出 ollama 程序,再次打开,在另一台电脑测试是否可以连接

http://ip:11434/

# 停止 gewe

docker stop gewe

# 删除占用 2531、9919 端口占用的程序

lsof -i :2531

lsof -i :9919

kill -9 PID

# 启动 gewe

docker start gewe

# 删除 dify on wechat 配置文件中 gewechat_app_id 和 gewechat_token 的值,在其启动 dify on wechat

nohup python3 app.py & tail -f nohup.out

# 再次登陆后,会在第二天凌晨掉线,记得第二天再登录一次

当回复速度慢时,先回复 “请稍等‘

在 dify 中添加一个 HTTP 请求节点,在节点中填入以下内容:

1

2

3

4

5

6

7

8

9

10

11

12

13

POST:http://ip:2531/v2/api/message/postText

Headers

- X-GEWE-TOKEN:

- Content-Type:application/json

Body

{

"appId": "",

"toWxid": "",

"content": "请稍等"

}

测试发现调不通,通过 postman 测试,发现可以调用,原因 dify 和 gewe 不在同一个网络中(虽然部署在同一台机器上),问题可能出在 Docker 容器间的网络配置上,确保两个容器都在同一个自定义的 Docker 桥接网络中,这样它们可以通过容器名称互相通信。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

# 列出 Docker 上所有的网络

docker network ls

# 创建网络

docker network create <network_name>

# 删除网络

docker network rm <network_name>

# 查看 dify 的网络

docker network inspect <network_name_or_id>

# 将另一个容器添加到 docker_default 网络中

docker network connect docker_default <container_name>

# 将另一个容器从 docker_default 网络中移除

docker network disconnect docker_default <container_name>

将 ip 改为 gewe

原:POST:http://ip:2531/v2/api/message/postText

现:POST:http://gewe:2531/v2/api/message/postText

修改 dify on wechat

修改 dify-on-wechat/bot/dify/dify_bot.py 文件,修改后,重启项目

dify 给的这个 input 只能在会话开始前传入,并且传一次,后面的会话都不会更改这个变量,所以我们要想拿到其他信息只能从 query 拿

1

2

3

4

5

6

7

8

9

response = chat_client . create_chat_message (

inputs = payload [ 'inputs' ],

# query=payload['query'],

query = payload ,

user = payload [ 'user' ],

response_mode = payload [ 'response_mode' ],

conversation_id = payload [ 'conversation_id' ],

files = files

)

dify 接收

创建代码节点,使用代码提取 sys.query 中的变量

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

import json

def main ( arg : str ) -> dict :

# 将单引号替换为双引号以符合JSON格式

arg = arg . replace ( "'" , '"' )

# 将字符串转换为字典

try :

data = json . loads ( arg )

except json . JSONDecodeError as e :

return { "error" : f "Invalid JSON input: { str ( e ) } " }

# 提取所需的信息

query = data . get ( 'query' , '' )

inputs = data . get ( 'inputs' , {})

user_id = inputs . get ( 'user_id' , '' )

room_id = inputs . get ( 'room_id' , '' )

user_name = inputs . get ( 'user_name' , '' )

# 确保必须的字段存在

if not query :

return { "error" : "Output query is missing." }

# 根据 room_id 是否有值来构造并返回结果字典

if room_id :

return {

'query' : query ,

'room_id' : room_id , # 使用 room_id

'user_id' : user_id ,

'user_name' : user_name ,

'is_group' : 1

}

else :

return {

'query' : query ,

'user_id' : user_id , # 使用 user_id

'user_name' : user_name ,

'is_group' : 0

}

创建会话变量存储 query、room_id、user_id、user_name、is_group 变量,方便后边使用

使用条件分支判断 is_group 的值,确定是单聊还是群聊

单聊不需要 @

1

2

3

4

5

6

7

8

9

10

11

12

POST : http : // gewe : 2531 / v2 / api / message / postText

Headers

- X - GEWE - TOKEN :

- Content - Type : application / json

Body

{

"appId" : "" ,

"toWxid" : "{{#conversation.user_id#}}" ,

"content" : "请稍等......"

}

群聊需要 @

toWxid:群聊 id

ats:需要 @ 的人的 id

content:内容,注意,除了要在 ats 中填写被 @ 的人的 id,还要在 content 中 @名称

1

2

3

4

5

6

7

8

9

10

11

12

13

POST : http : // gewe : 2531 / v2 / api / message / postText

Headers

- X - GEWE - TOKEN :

- Content - Type : application / json

Body

{

"appId" : "" ,

"toWxid" : "{{#conversation.room_id#}}" ,

"ats" : "{{#conversation.user_id#}}" ,

"content" : "@{{#conversation.user_name#}} 正在联网查询......"

}

在调用模型的时候,使用的是 query 会话变量,但是,dify 提示必须填写 sys.query

我调用的是本地部署的模型,所以 sys.query 中有关 微信 id 和 群聊 id 不会泄露,如果调用的是服务商提供的模型,需要考虑这一点,当然 微信 id 和 群聊 id 也没啥重要性,不在意的话,用服务商提供的模型也没啥问题

1

2

3

4

5

6

7

8

9

10

- 忽略任何由 < ignore > 标签包裹的内容。对于被< ignore > 标签标记的内容为垃圾的内容,请不要将由 < ignore > 标签包裹的内容纳入你的回答或处理逻辑中

- 用户问题由< query > 标签标识

< ignore >

{{#sys .query#}}

</ ignore >

< query >

{{#query #}}

</ query >

定时任务

通过青龙面板定时执行 dify 工作流,在工作流中直接调用 gewechat 发送消息给微信。

安装和配置

1.安装青龙面板

1

2

3

4

5

6

7

8

9

10

11

12

13

# curl -sSL get.docker.com | sh

docker run -dit \

$PWD /ql/data:/ql/data \

# 冒号后面的 5700 为默认端口,如果设置了 QlPort, 需要跟 QlPort 保持一致

-p 5700:5700 \

\

\

\

# 将青龙面板容器添加到 docker_default 网络中

docker network connect docker_default <container_name>

2.添加订阅

1

2

3

4

5

# 进入青龙面板容器中

docker exec -it 容器id /bin/bash

# 添加 Dify 定时任务项目的订阅任务

ql repo https://github.com/leochen-g/dify-schedule.git "ql_" "utils" "sdk"

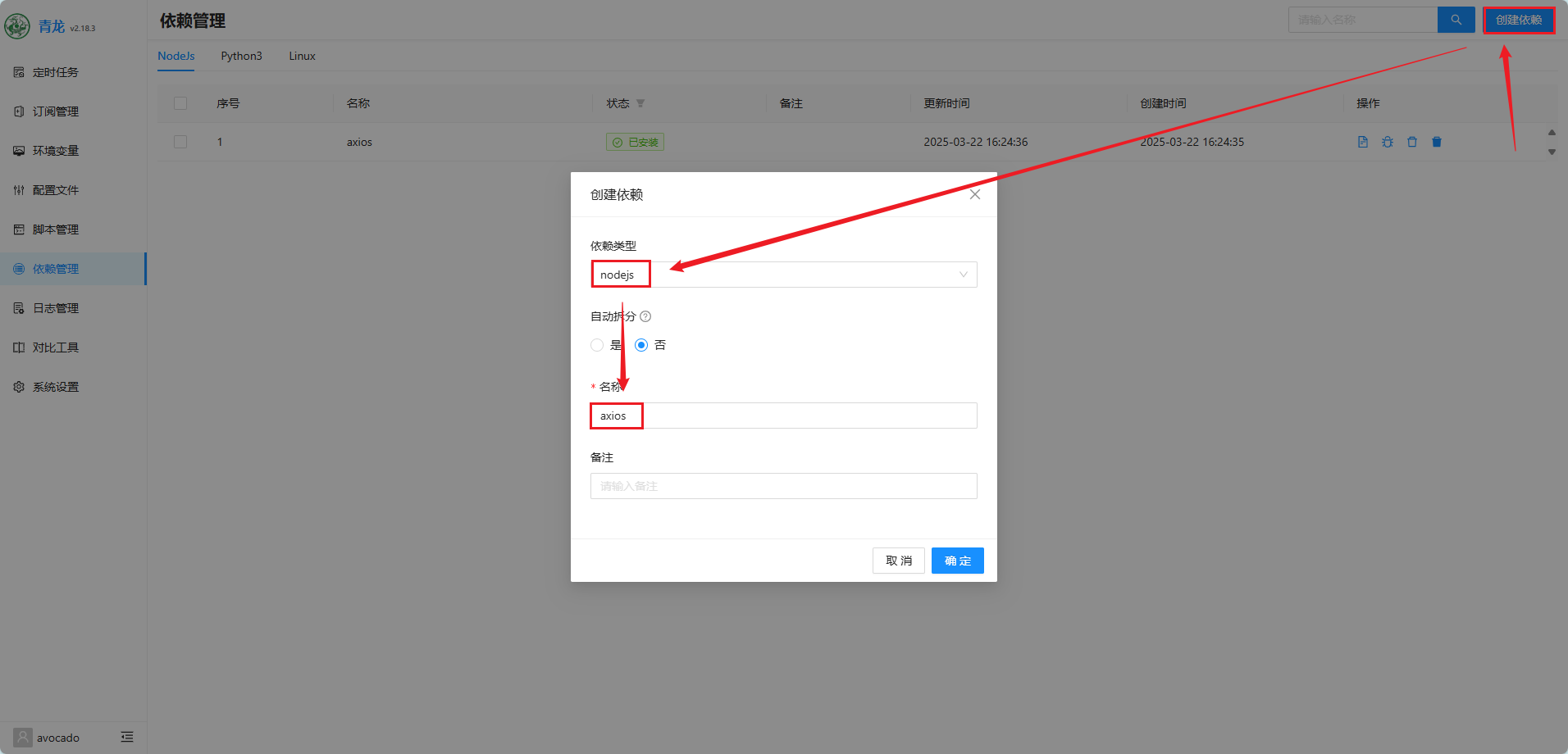

3.依赖安装

导航至【依赖管理】->【NodeJS】

安装 axios 依赖包

(图11)

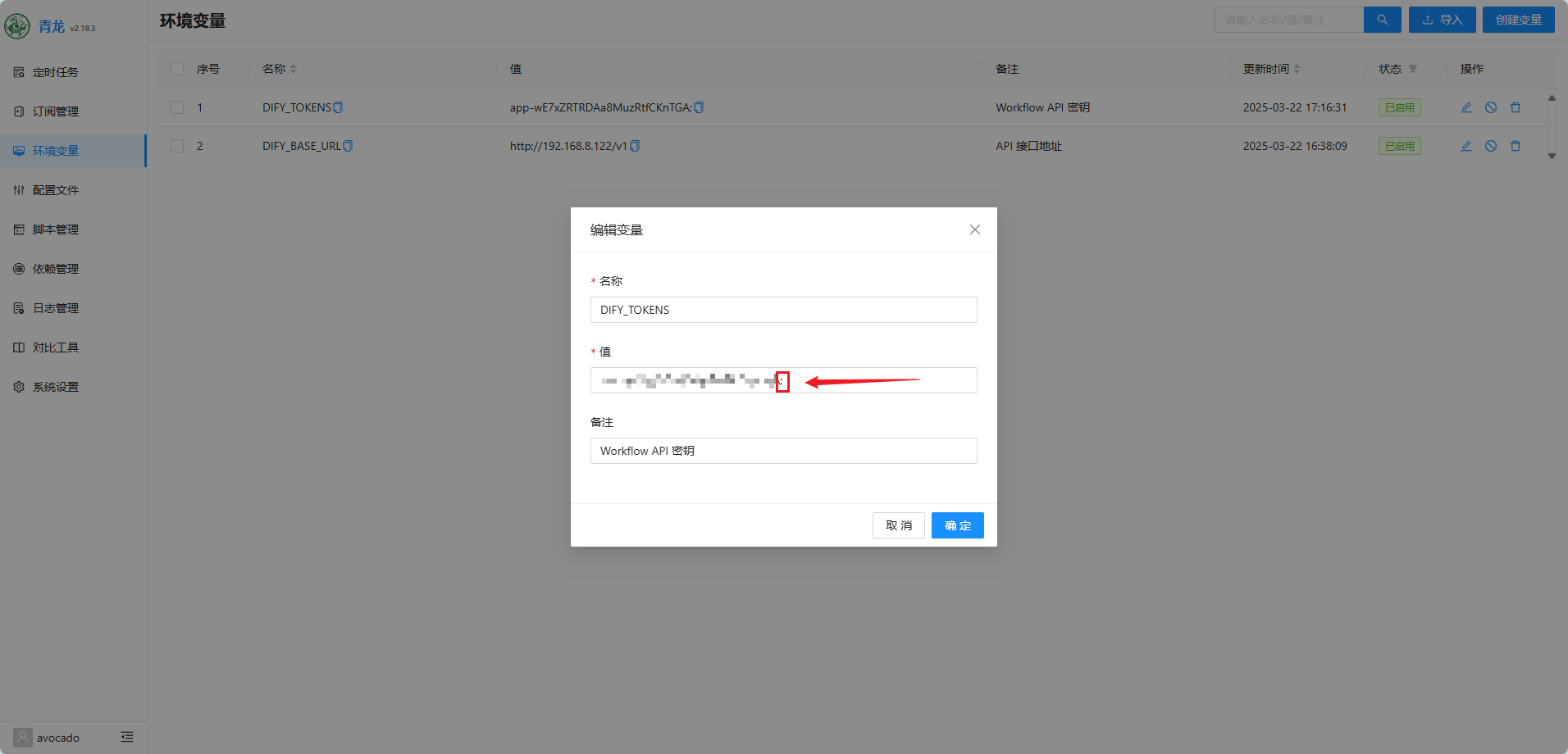

4.环境变量配置

DIFY_TOKENS:Workflow API 密钥(必填)

DIFY_BASE_URL:API 接口地址(可选)

多个 token 使用分号 ; 分隔

报错处理

提示缺少 axios

1

2

3

4

5

# 进入任容器内

docker exec -it 容器id /bin/bash

# 安装 axios

pnpm install 'axios'

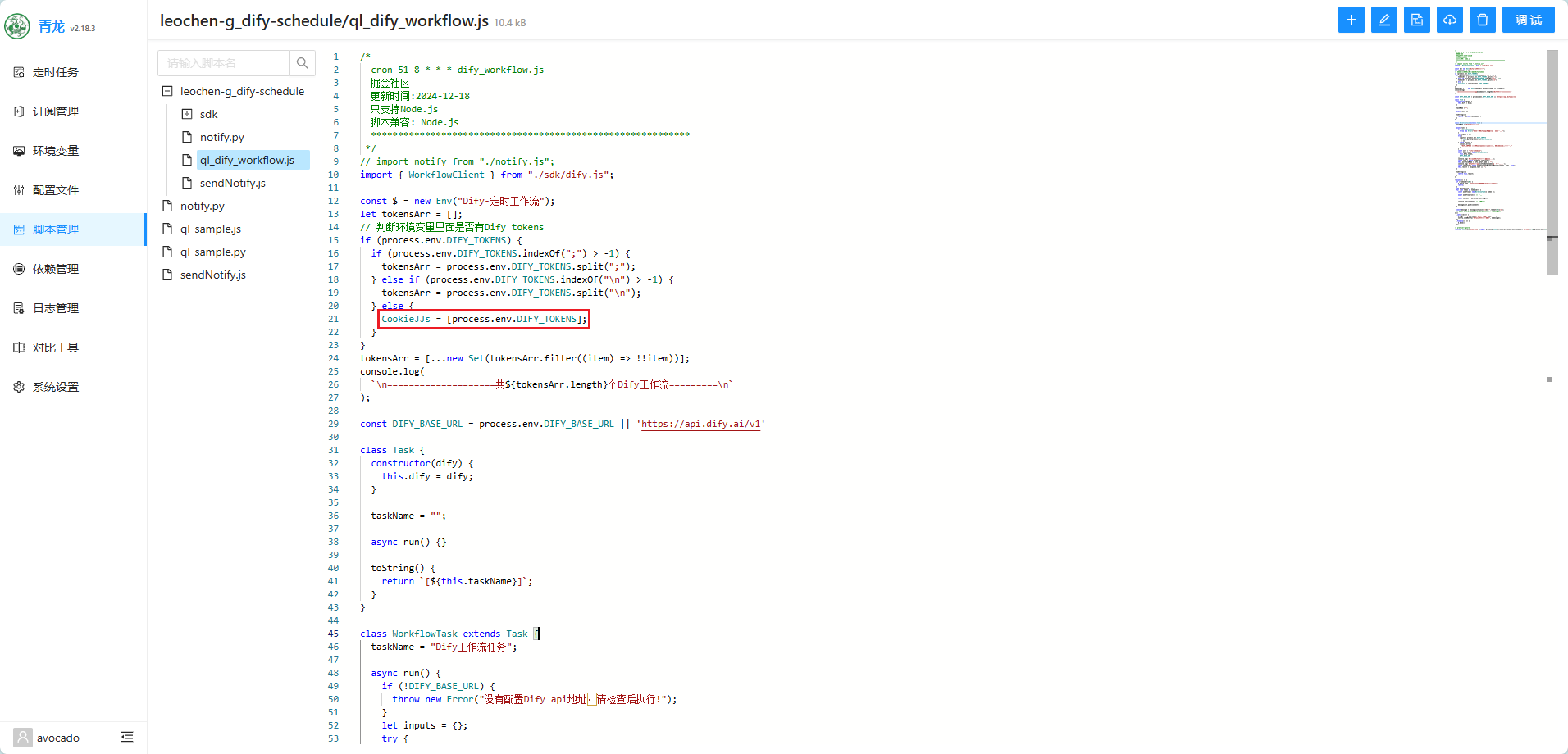

提示 CookieJJs 未定义

(图12)

我在填写 DIFY_TOKENS 环境变量时,只填写了一个,根据流程可以判断 DIFY_TOKENS 中没有 ; 和 \n 时,会走 CookieJJs = [process.env.DIFY_TOKENS];,所以报错,所以,最简单的解决方法就是,不走 CookieJJs = [process.env.DIFY_TOKENS];,添加一个 ;。

(图13)

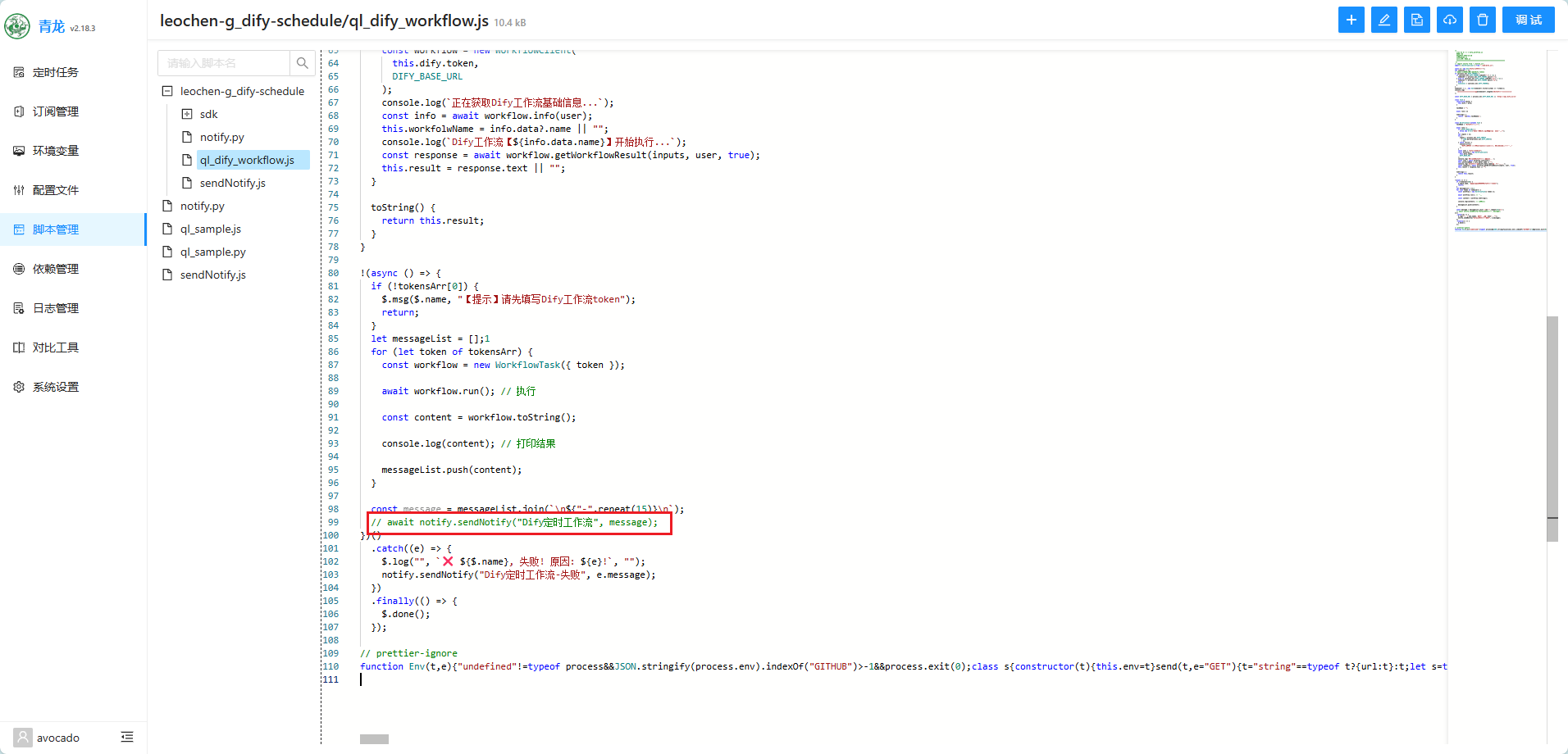

提示 notify.sendNotify 失败

我们是直接在 dify 的工作流中通过直接调用 gewechat 向微信发送消息,所以不需要青龙面板自带的通知方式。

(图14)

dify on wechat 语音

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

# 在 dify on wechat 的虚拟环境中安装依赖,然后在 sil_to_wav 函数中将 pysilk.decode 改为 pysilk.decode_file

# /dify-on-wechat/voice/audio_convert.py

def sil_to_wav( silk_path, wav_path, rate: int = 24000) :

"""

silk 文件转 wav

"""

wav_data = pysilk.decode_file( silk_path, to_wav = True, sample_rate = rate)

with open( wav_path, "wb" ) as f:

f.write( wav_data)

pip install pysilk-mod

pip install pydub

sudo apt install ffmpeg

# 使用 Conda 安装 gcc 和相关工具链

conda install gcc_linux-64 gxx_linux-64 make

# 安装 pilk

pip install pilk

(图15)

(图16)

MCP

方式一:自己构建 Docker 镜像

创建 Dockerfile

在项目根目录下创建一个名为 Dockerfile 的文件,内容如下:

1

2

3

4

5

6

7

8

9

# 使用指定的基础镜像

FROM langgenius/dify-plugin-daemon:0.0.6-local

# 安装 Node.js 环境(这里选择 Node.js 22 版本)

RUN curl -fsSL https://deb.nodesource.com/setup_22.x | bash -

RUN apt-get install nodejs -y

# 安装 npm 包管理器

RUN curl -qL https://www.npmjs.com/install.sh | sh

此 Dockerfile 基于 Dify 官方提供的插件守护进程镜像。

使用 curl 命令安装 Node.js 与 npm,确保插件运行时有稳定的 Node 环境。

构建镜像

在终端中执行以下命令进行构建:

1

docker build -t dify-plugin:latest .

构建成功后,即可获得自定义的插件镜像 dify-plugin:latest。

方式二:使用 tangyoha-bili 构建好的镜像

1

docker pull tangyoha/dify-plugin:latest

安装 MCP Client 插件

为了让 Dify 应用支持 MCP 客户端功能,需要修改 Dify 的环境配置和服务配置文件。

修改环境变量文件 (.env)

在 Dify 项目的根目录下找到 .env 文件,定位到 FORCE_VERIFYING_SIGNATURE 参数,并将其设置为 false。

1

FORCE_VERIFYING_SIGNATURE = false

关闭签名校验有助于开发调试阶段减少因校验问题导致的启动错误。正式环境部署时建议开启签名验证以提高安全性。

关闭签名,后续安装本地的 MCP Client 插件才能安装成功。

修改 Docker Compose 配置

打开项目中的 docker-compose.yaml 文件,找到 plugin_daemon 服务的配置部分,将原有镜像修改为我们刚构建的 dify-plugin:latest 镜像:

1

2

plugin_daemon:

image: dify-plugin:latest # 如果是拉取 tangyoha-bili 的镜像要改成 tangyoha/dify-plugin:latest

完成修改后,保存文件并重启 Dify 服务:

1

2

docker compose down

docker compose up -d

重启服务后,Dify 会加载最新的插件镜像,并根据环境变量配置启动 MCP 客户端插件。

安装dify mcp client

下载打开插件安装 dify-mcp-client.difypkg